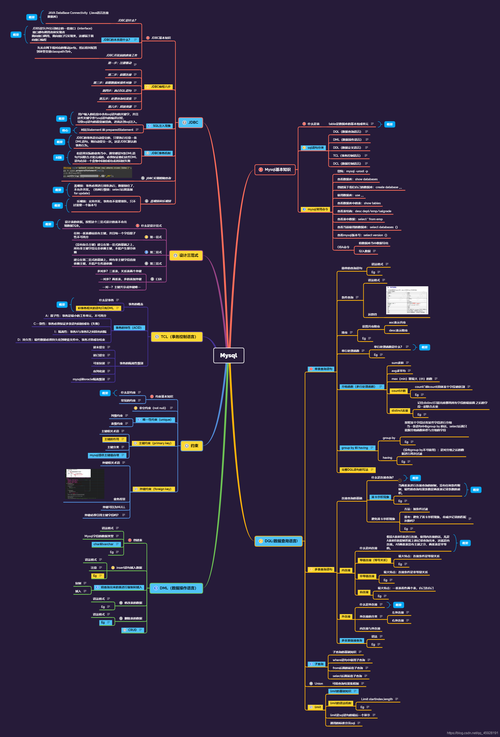

如何在MySQL中高效导入千万级别的数据?

在当今的大数据时代,MySQL作为一种广泛使用的开源关系型数据库管理系统,在数据的导入导出操作上扮演着重要角色,特别是当涉及到千万级别的大规模数据迁移时,如何高效、准确地完成这一操作成为了一个值得探讨的问题,本文将深入分析MySQL数据库在处理大规模数据时的导出与导入策略,旨在为数据库管理员提供一套实用、高效的解决方案。

(图片来源网络,侵删)

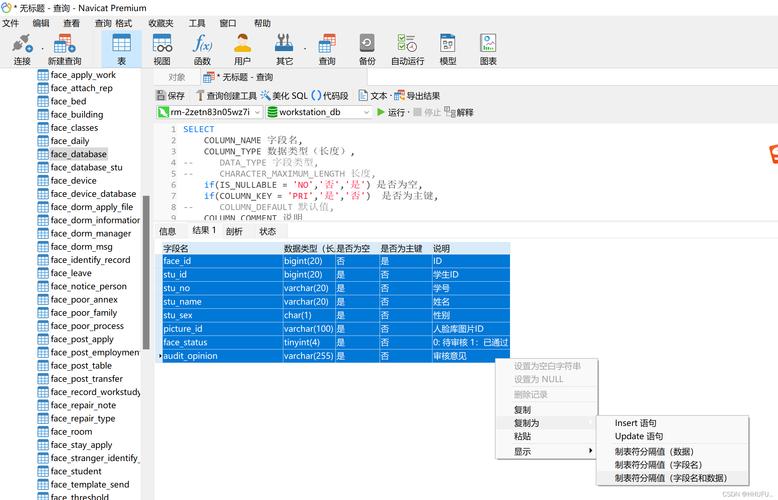

(图片来源网络,侵删)数据导出前的准备

在开始导出大规模数据之前,确保数据库的性能和稳定性是首要任务,这包括检查服务器的硬件资源(如CPU、内存和存储空间),优化数据库表的结构,以及关闭不必要的应用程序和服务以释放资源,评估数据量大小和网络带宽也是成功导出数据的关键步骤。

选择合适的导出工具

对于百万到千万级别的数据量,mysqldump是一个常用的选择,它能够生成包含创建表、插入数据等SQL语句的转储文件,虽然使用mysqldump导出大量数据可能会产生较大的文件(通常在1GB左右),并且耗时较长,但它的优点是可以直接用于数据的备份和迁移。

优化数据导出过程

为了提高导出效率,可以采取以下几种策略:

并行导出:将数据分成小块,在多个线程或进程中并行执行导出操作。

(图片来源网络,侵删)

(图片来源网络,侵删)选择性导出:只导出必要的数据或表,减少导出的数据量。

压缩:在导出时启用压缩选项,以减少导出文件的大小。

数据导入策略

对于千万级别的数据导入,MySQL提供了多种方法来优化性能:

LOAD DATA INFILE:这是一个非常快速的加载数据的方法,它直接将文本文件的数据加载到数据库表中,这种方法比逐条插入数据要快得多。

并行加载:利用MySQL的多线程功能,将数据文件分成多个小文件,然后并行加载。

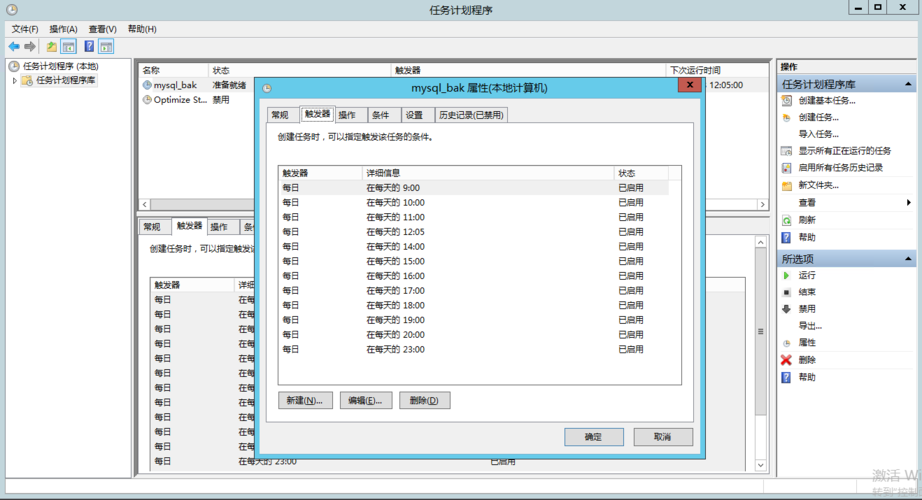

优化my.cnf设置:调整诸如innodb_buffer_pool_size、innodb_log_file_size等参数,以提高导入过程中的I/O和事务处理性能。

(图片来源网络,侵删)

(图片来源网络,侵删)导入前的准备工作

在进行大规模数据导入之前,确保目标数据库的表结构已经设置好,并且根据数据量预估合理分配了存储空间,暂时禁用不必要的索引和触发器,可以在导入过程中显著提高速度。

实际操作中的注意事项

监控资源使用情况:在导入导出过程中,持续监控内存、CPU和磁盘I/O的使用情况,及时调整资源分配,避免出现性能瓶颈。

事务管理:适当使用事务可以提升导入的性能,尤其是在遇到错误需要回滚时。

错误处理:准备好错误处理机制,比如记录日志,以便在出现故障时快速恢复。

相关案例分析

假设有一个电商平台需要进行大促期间的数据迁移,涉及千万级别的商品信息和用户行为数据,通过上述策略,数据库管理员首先使用mysqldump导出数据,并采用scp命令将数据文件传输到新的服务器,之后,利用LOAD DATA INFILE命令并行加载数据到新数据库中,整个过程在几小时内顺利完成,大大缩短了系统的停机时间。

FAQs

Q1: 为什么在导出大数据量时推荐使用mysqldump?

A1: mysqldump是官方提供的备份工具,它可以确保数据的一致性和完整性,虽然导出大数据量时耗时较长,但它生成的SQL文件可直接用于数据恢复,非常适合备份和迁移场景。

Q2: 在导入千万级别的数据时,有哪些常见的性能优化技巧?

A2: 常见的性能优化技巧包括使用LOAD DATA INFILE快速加载数据,暂时禁用索引和触发器减少导入时间,调整my.cnf参数优化数据库性能,以及并行加载数据减少总体所需时间。

MySQL数据库在处理千万级别数据的导出与导入时,通过合理的准备、选择合适的工具和优化策略,可以大幅提高效率和准确性,通过实际操作中的注意事项和案例分析,我们进一步了解了如何在实际应用中灵活运用这些策略,确保大规模数据迁移的顺利进行。